-

Was ist eine IO-Verzögerung in Proxmox?

-

Was ist eine akzeptable E/A-Verzögerung?

-

Wie findet man die Ursache für Proxmox-IO-Verzögerungen heraus?

-

Zuverlässige Proxmox VM-Sicherungslösung

-

Proxmox IO-Verzögerungs-Häufig gestellte Fragen

-

Fazit

Die Speicherung ist entscheidend für die VM-Leistung. IO-Verzögerung zeigt Wartezeiten des Speichers an. Sie kann VMs verlangsamen und Administratoren frustrieren. Dieser Artikel erklärt die IO-Verzögerung in Proxmox VE. Sie erfahren, was sie bedeutet, welche Werte akzeptabel sind und wie Sie die Ursachen auf Anfänger-, mittlerem und fortgeschrittenem Niveau nachverfolgen können.

Was ist eine IO-Verzögerung in Proxmox?

Die IO-Verzögerung zeigt, wie viel Zeit Prozesse auf Datenträgeroperationen warten. Proxmox VE meldet die IO-Verzögerung in der Summary-Ansicht des Knotens, um Administratoren bei der Erkennung von Speicherengpässen zu unterstützen. Sie basiert auf der iowait-Metrik der Linux-Blockschicht und verfolgt die CPU-Leerlaufzeit bei ausstehenden E/A. In der Praxis aggregiert die IO-Verzögerung die Wartezeiten aller Prozesse auf dem Host und erfasst Kernel-Statistiken regelmäßig per Stichprobe.

Die E/A-Verzögerung von Proxmox unterscheidet sich von der reinen CPU-Auslastung. Eine hohe CPU-Auslastung kann auf rechenintensive Aufgaben hinweisen, während eine hohe E/A-Verzögerung zeigt, dass das Speichersystem nicht mithalten kann. Diese Metrik hilft dabei, Verlangsamungen durch Festplattenprobleme zu identifizieren. Sie korreliert mit dem Linux-Wert %iowait, der von Tools wie iostat angezeigt wird. Wenn die E/A-Verzögerung ansteigt, warten Prozesse darauf, dass Lese- oder Schreibvorgänge abgeschlossen werden, wodurch VM-Aufgaben sowie Vorgänge wie Snapshots oder Backups verzögert werden.

Proxmox erfasst die E/A-Verzögerung, indem es die Anzahl der Aufgaben im nicht unterbrechbaren Schlafzustand (D-Zustand) zählt, die auf Festplatten-E/A warten. Sie gibt die gesamte Wartezeit als Prozentsatz der gesamten CPU-Zeit an. Diese Erfassung liefert eine knotenbezogene Ansicht, die von den pro VM-Metriken getrennt ist. Administratoren können sie in Echtzeit über die Web-Oberfläche überwachen oder Metriken über APIs für externe Dashboards abrufen.

Die E/A-Verzögerung reagiert schnell auf die Speicherbelastung. Beispielsweise führt das Klonen einer VM zu hohen Festplattenlesevorgängen, wodurch die E/A-Verzögerung ansteigt, bis der Kopiervorgang abgeschlossen ist. Ebenso können intensive Schreibvorgänge aus einer VM heraus diese erhöhen. Die Beobachtung der E/A-Verzögerungstrends hilft dabei, verzögerte VM-Antworten mit zugrundeliegendem Speicherdruck in Verbindung zu bringen. Zusammenfassend ist die E/A-Verzögerung die Proxmox-Darstellung von Speicherwartevorgängen, basierend auf Linux iowait, und ermöglicht es Administratoren, Speicherprobleme frühzeitig zu erkennen.

Was ist eine akzeptable E/A-Verzögerung?

Eine akzeptable E/A-Verzögerung stellt sicher, dass die Reaktionsfähigkeit der VM innerhalb der Servicelevel bleibt. Bei geringer oder moderater Auslastung haben Werte unter 5 % oft keine sichtbaren Auswirkungen. Aufflammungen auf 10–15 % können während Aufgaben wie Backups oder Live-Migrationen auftreten, ohne Schaden anzurichten, solange sie kurz sind. Dauerhafte Werte über 20 % deuten jedoch typischerweise auf Speicherbelastung hin, die Maßnahmen erfordert.

Die Art der Workload beeinflusst die Schwellenwerte. In einem Heimlabor können kurze Phasen mit höherer Verzögerung akzeptabel sein. Im Produktionsbetrieb können bereits kurze Spitzen latenzsensible Dienste stören. Fragen Sie sich: Ist die Workload latenzkritisch? Wenn ja, sollte die Verzögerung meist unter 5 % liegen, und längere Spitzen sollten vermieden werden. Bei Batchaufgaben, die außerhalb der Hauptlastzeiten laufen, kann eine höhere Verzögerung zugelassen werden. Trends sind wichtig: Verfolgen Sie die IO-Verzögerung über Tage oder Wochen, um einen ansteigenden Grundwert frühzeitig zu erkennen.

Muster beobachten: gelegentliche Spitzen während Sicherungen können normal sein, wenn sie geplant sind. Bleibt die E/A-Verzögerung jedoch im Leerlauf erhöht, prüfen Sie die Speicherintegrität oder -konfiguration. Viele Administratoren betrachten einen anhaltenden Wert über 10 % als Warnung und über 20 % als kritisch. Einige halten 30 % bei hoher Auslastung kurzfristig für akzeptabel, sollten dies aber nicht dauerhaft zulassen. Sehr hohe Spitzen (50 %+) führen oft zu reaktionslosen VMs und erfordern sofortige Gegenmaßnahmen.

Unterschiedliche Speicher beeinflussen die Toleranz: SSD-Arrays verarbeiten mehr IOPS und weisen unter Last eine geringere Verzögerung auf. HDDs oder gemischte Pools können früher eine höhere Verzögerung erreichen. Netzwerkspeicher wie NFS oder iSCSI können Latenz hinzufügen. Bei Ceph oder anderen verteilten Speichern wirkt sich auch die Netzwerklast auf die IO-Verzögerung aus. Verstehen Sie die Fähigkeiten Ihres Speichers und passen Sie die Verzögerungsschwellen entsprechend an.

Proxmox-Version und -Konfiguration können entscheidend sein. Neuere Kernel und Treiber verbessern oft die Leistung und verringern die E/A-Wartezeit. Aktualisierte Proxmox-VE-Versionen können eine optimierte Scheduler-Einstellung oder eine bessere Unterstützung für Multi-Queue enthalten. Testen Sie nach Aktualisierungen stets die Schwellenwerte. Zusammenfassend hängt eine akzeptable E/A-Verzögerung von der Arbeitslast, der Speicherlösung und der Risikotoleranz des Administrators ab, liegt aber typischerweise unter 5 %; bei anhaltenden Werten über 20 % ist eine Überprüfung erforderlich.

Wie findet man die Ursache für Proxmox-IO-Verzögerungen heraus?

Das Auffinden der Ursachen erfordert schichtweise Überprüfungen, beginnend bei der Hardware bis hin zum Gastsystem. Beginnen Sie mit einfachen Zustandsprüfungen und gehen dann zu einer detaillierten Analyse über.

1. Überprüfung der grundlegenden Hardware-Integrität

Überprüfen Sie zuerst die Laufwerksintegrität und grundlegende Metriken. Verwenden Sie smartctl -H auf den Festplatten, um sicherzustellen, dass diese einen gesunden Status melden. Überhitzte SSDs können sich drosseln und dadurch unerwartet die E/A-Verzögerung erhöhen. Prüfen Sie die Laufwerkstemperaturen über SMART-Attribute und Server-Sensoren. Anschließend überprüfen Sie die Integrität des RAID-Controllers oder des ZFS-Pools mittels zpool status. Defekte Festplatten oder degradierte Arrays können Verzögerungen verursachen.

Testen Sie die einfache Ein-/Ausgabe: Führen Sie dd if=/dev/zero of=/path/to/storage/testfile bs=1M count=1024 oflag=direct innerhalb einer Test-VM oder auf dem Host aus. Beobachten Sie die Durchsatzkonsistenz. Unerwartet niedrige Geschwindigkeiten deuten auf Hardware- oder Konfigurationsprobleme hin. Überprüfen Sie auf dieser Ebene auch Kabelverbindungen und Stromversorgung: lose Kabel oder eine ausfallende Stromquelle können die Speicherleistung beeinträchtigen.

2. Überwachen Sie die Aktivitäten auf Betriebssystemebene

Überwachen Sie als Nächstes die Ein-/Ausgabeaktivität im Host-Betriebssystem. Führen Sie iostat -x 1 aus, um die Gerätenutzung, Wartezeiten und Warteschlangenlängen anzuzeigen. Achten Sie auf %util nahe 100 % oder hohe await-Werte, die auf Sättigung hinweisen. Verwenden Sie iotop, um Prozesse mit hohem Ein-/Ausgabevolumen zu identifizieren. Filtern Sie nach root: sudo iotop -ao. Suchen Sie nach QEMU oder Sicherungsprozessen, die auf die Festplatten zugreifen. Stellen Sie eine Verbindung zwischen Spitzen der Ein-/Ausgabeaktivität und Anstiegen der E/A-Verzögerung in den Protokollen der Proxmox-Oberfläche her.

Überprüfen Sie die CPU-Zustände: Verwenden Sie mpstat 1 oder vmstat 1, um %iowait anzuzeigen. Ein hoher iowait-Wert steht in Zusammenhang mit IO-Verzögerungen. Beachten Sie jedoch, dass iowait Probleme pro Gerät verbergen kann; überprüfen Sie daher immer die Statistiken pro Festplatte. Verwenden Sie lsblk oder df -h, um zu bestätigen, welche Festplatten welche VMs unterstützen.

Wenn Netzwerkspeicher verwendet wird, überprüfen Sie die Netzwerkgesundheit: ping an NAS oder Speicherziel; iperf3 zwischen Hosts zur Messung der Bandbreite. Hohe Latenzzeiten oder geringe Durchsatzraten können die IO-Verzögerung erhöhen. Bei NFS/iSCSI prüfen Sie die Einhängoptionen: Falsche Einstellungen (noasync gegenüber async) können die Leistung beeinträchtigen.

3. Speicherstack überprüfen

Untersuchen Sie die Details der Speicherebene. Verwenden Sie bei ZFS den Befehl zpool iostat -v 1, um die I/O auf Pooletebene, Statistiken pro vdev sowie die Lese-/Schreibverteilung anzuzeigen. Wenn der ARC klein ist, greifen Lesevorgänge häufig direkt auf die Festplatten zu, was die Verzögerung erhöht. Erwägen Sie eine Optimierung des ARC: Erhöhen Sie den Cache, sofern genügend Arbeitsspeicher verfügbar ist, behalten Sie aber ausreichend Reserven für VMs bei.

Prüfen Sie bei LVM die Thin- und Thick-Bereitstellung: Thin-Pools können fragmentieren und langsame Metadatenoperationen verursachen. Verwenden Sie lvs -a -o+seg_monitor, um die Gesundheit des Thin-Pools zu überprüfen. Bei LVM auf Netzwerkspeicher stellen Sie sicher, dass die Volumenausrichtung mit den zugrunde liegenden Speicherblöcken übereinstimmt, um zusätzlichen Overhead zu vermeiden.

Überwachen Sie bei Ceph die OSD-Leistung über das Ceph-Dashboard. Hohe OSD-Latenz beeinträchtigt direkt die Proxmox-IO-Verzögerung. Überprüfen Sie den Netzwerkdurchsatz in den öffentlichen und Cluster-Netzwerken. Stellen Sie sicher, dass keine überlasteten Verbindungen vorhanden sind.

Dateisystemauswahl überprüfen: XFS, ext4 oder ZFS verhalten sich unterschiedlich unter Last. Metadatenintensive Workloads können auf Dateisystemen mit ungeeigneten Journaling-Einstellungen langsamer werden. Überprüfen Sie die Mount-Optionen; bei ext4 sollten Barrieren nur deaktiviert werden, wenn dies sicher ist.

4. Proxmox-Konfiguration überprüfen

Führen Sie pveperf auf den Knoten aus, um fsync/sync und die Basislinie der Festplatten-E/A zu messen. Eine niedrige Anzahl von fsync/Sekunde deutet auf langsame Metadatenoperationen hin. Vergleichen Sie die Ergebnisse zwischen den Knoten. Stellen Sie sicher, dass Hardware und Einstellungen einheitlich sind.

Beobachten Sie im Proxmox-GUI, welcher VM die IO-Verzögerung auslöst. Nutzen Sie den Taskverlauf: Prüfen Sie die Zeitstempel, zu denen die Verzögerung anstieg. Vergleichen Sie dies mit den VM-Aktivitäten: Backups, Snapshots, Live-Migrationen. Erwägen Sie, aufwändige Aufgaben in Zeiten geringerer Auslastung zu planen.

Überprüfen Sie die VM-Festplatteneinstellungen: bevorzugen Sie VirtIO SCSI oder VirtIO Block mit Caching-Einstellung writeback oder none, abhängig von der Arbeitslast. Vermeiden Sie unsichere Caches in Produktionsumgebungen. Installieren und aktualisieren Sie im Gastbetriebssystem die VirtIO-Treiber für optimale Leistung. Für Windows-VMs verwenden Sie das neueste VirtIO-ISO. Für Linux-Gäste stellen Sie sicher, dass die Module virtio-blk oder virtio-scsi geladen sind.

Überprüfen Sie die Proxmox-Speicherkonfiguration: Stellen Sie bei speicherbasierten Verzeichnissen sicher, dass die Leistung des Host-Dateisystems ausreicht. Überprüfen Sie bei LVM-thin die Fragmentierung des Thin-Pools. Prüfen Sie bei ZFS die recordsize: Wählen Sie eine recordsize, die zur VM-Workload passt (z. B. 16K für Datenbanken, 128K für allgemeine Nutzung). Passen Sie bei Ceph die rbd-Features und das Caching an.

5. Protokolle überprüfen

Überprüfen Sie dmesg auf Speichertreiberfehler: Zeitüberschreitungen, Rücksetzungen. Häufige Fehler beeinträchtigen die Leistung. Prüfen Sie /var/log/syslog und /var/log/kern.log auf wiederholte E/A-Fehler oder Warnungen. In den VM-Protokollen unter /var/log/pve/tasks suchen Sie nach Fehlern bei Sicherungs- oder Migrationsaufgaben.

Wenn Hardwareprobleme vermutet werden, überprüfen Sie die RAID-Logs oder Herstellerwerkzeuge (z. B. MegaCLI, storcli) auf Array-Warnungen. Für SMART untersuchen Sie erweiterte Attribute: smartctl -a /dev/sdX für umgeleitete Sektoren oder ausstehende Sektoren.

6. Abstimmung und Testen

Linux-I/O-Planer abstimmen: bei rotierenden Datenträgern den deadline-Planer verwenden; bei SSDs none oder mq-deadline im Mehrfachwarteschlangenmodus verwenden. Änderung über: echo mq-deadline > /sys/block/sdX/queue/scheduler. Änderungen unter kontrollierter Last testen; I/O-Verzögerung vorher und nachher überwachen.

ZFS-Parameter anpassen: ARC-Größe, ZIL/SLOG-Platzierung. Bei schreibintensiven Workloads SLOG-Gerät auf SSD mit geringer Latenz platzieren. Sicherstellen, dass die ZFS-Recordgröße zur Gast-Workload passt. Bei intensiven zufälligen Schreibvorgängen kann eine kleinere Recordgröße helfen. Überwachen Sie die ZFS-Latenz über zpool iostat.

Bei LVM-thin regelmäßig thin_repair ausführen oder heiße Daten in dicke Volumes konvertieren, falls die Thin-Fragmentierung hoch ist. Bei hohen Arbeitslasten Erweiterungen vorab zuordnen.

Anpassung des Netzwerkstapels: Bei NFS oder iSCSI die MTU (Jumbo-Frames) anpassen, falls das Netzwerk dies unterstützt. TCP-Fenstergrößen für Verbindungen mit hoher Latenz optimieren. Bei iSCSI mehrere Sitzungen oder Multipath aktivieren, um Redundanz und Durchsatz zu erhöhen.

Verwenden Sie erweitertes Benchmarking: Führen Sie fio in einer Test-VM oder auf dem Host aus, um Arbeitslasten zu simulieren. Zum Beispiel: fio --name=randread --ioengine=libaio --rw=randread --bs=4k --numjobs=4 --size=1G --runtime=60 --group_reporting. Vergleichen Sie Latenz und IOPS mit den erwarteten Kapazitäten.

Untersuchen Sie Kernel-Ebene-Metriken: Verwenden Sie perf oder blktrace, um die Blockebene detailliert zu verfolgen. Dies hilft dabei, Warteschlangenverzögerungen oder Scheduler-Konflikte genau zu identifizieren. Nutzen Sie während der Tests iostat -xk 1 und vmstat 1, um Korrelationen herzustellen.

Für extreme Skalierung die Speicherung auslagern: NVMe-oF oder dedizierte SAN-Arrays verwenden. Bei hyperkonvergenten Setups sicherstellen, dass das Clusternetzwerk ausschließlich für den Speicherverkehr mit QoS genutzt wird.

7. Kapazitätsplanung

Überwachen Sie das Speicherwachstum und die IOPS-Anforderungen über Wochen hinweg. Nutzen Sie historische Daten, um vorherzusagen, wann der Speicher voll ist. Tools wie Prometheus mit Proxmox-Exporter können IO-Verzögerungstrends im Zeitverlauf verfolgen. Planen Sie die Hinzufügung von Festplatten oder den Umstieg auf schnellere Speichermedien, bevor Probleme auftreten.

Planen Sie bei verteilten Speichern wie Ceph die Anzahl der OSDs und die Netzwerkbandbreite, um Spitzenlasten bewältigen zu können. Verwenden Sie Simulationswerkzeuge oder Machbarkeitsnachweise, um die Architektur zu testen.

Überlegen Sie eine gestufte Speicherlösung: Platzieren Sie häufig genutzte VM-Datenträger im SSD-Pool, selten genutzte auf HDD. Verschieben Sie VMs dynamisch basierend auf Nutzungsmustern. Nutzen Sie Proxmox Storage Migration, um Datenträger zu verschieben.

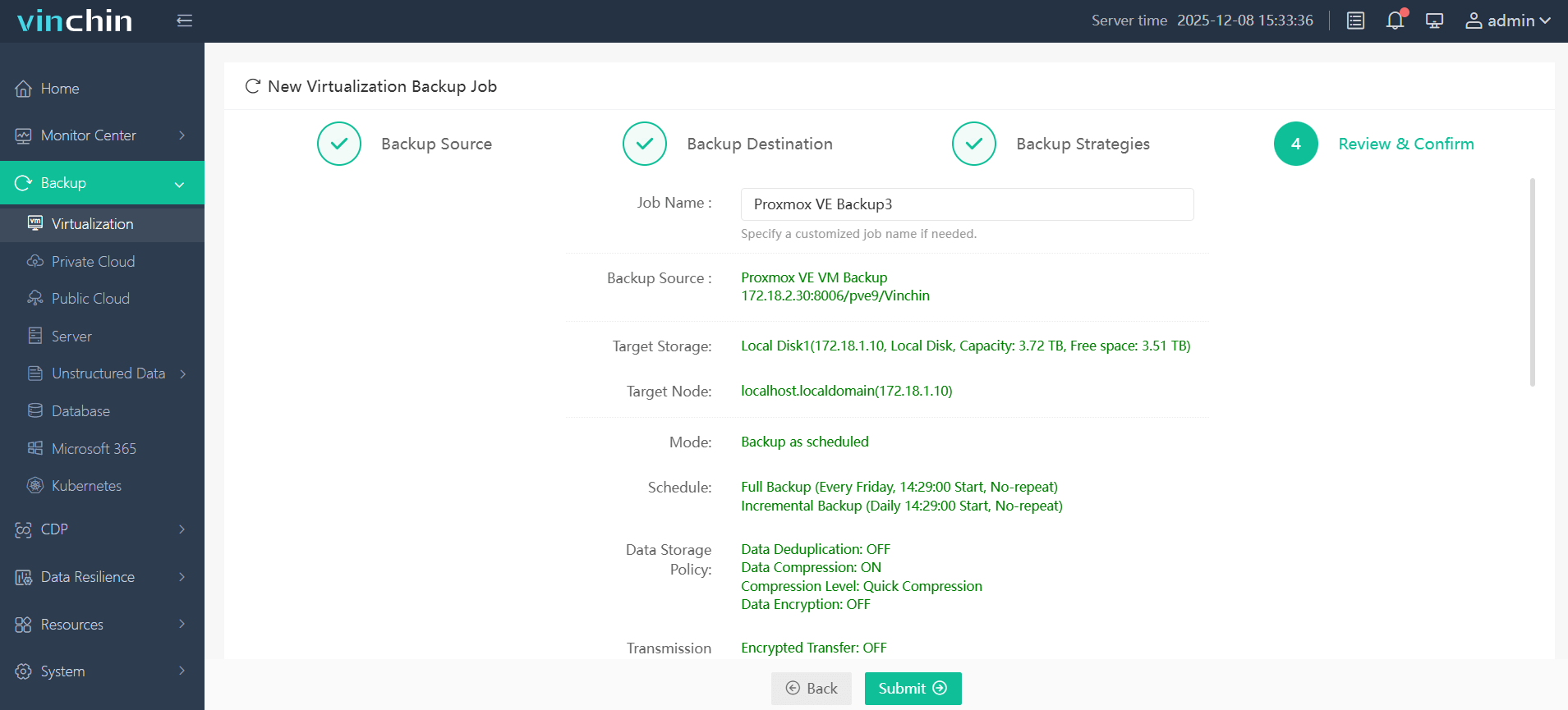

Zuverlässige Proxmox VM-Sicherungslösung

Bevor Sie die Speichereinstellungen anpassen, sichern Sie Ihre Daten mit einer zuverlässigen Backup-Lösung. Vinchin Backup & Recovery ist eine professionelle, unternehmensfähige VM-Sicherungslösung, die Proxmox neben VMware, Hyper-V, oVirt, OLVM, RHV, XCP-ng, XenServer, OpenStack, ZStack und über 15 Umgebungen unterstützt. Sie bietet Funktionen wie permanent inkrementelle Sicherung, Daten-Deduplizierung und -Komprimierung, V2V-Migration, Drosselungsrichtlinien und vieles mehr und bietet gleichzeitig zahlreiche zusätzliche Schutzmaßnahmen im Hintergrund.

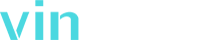

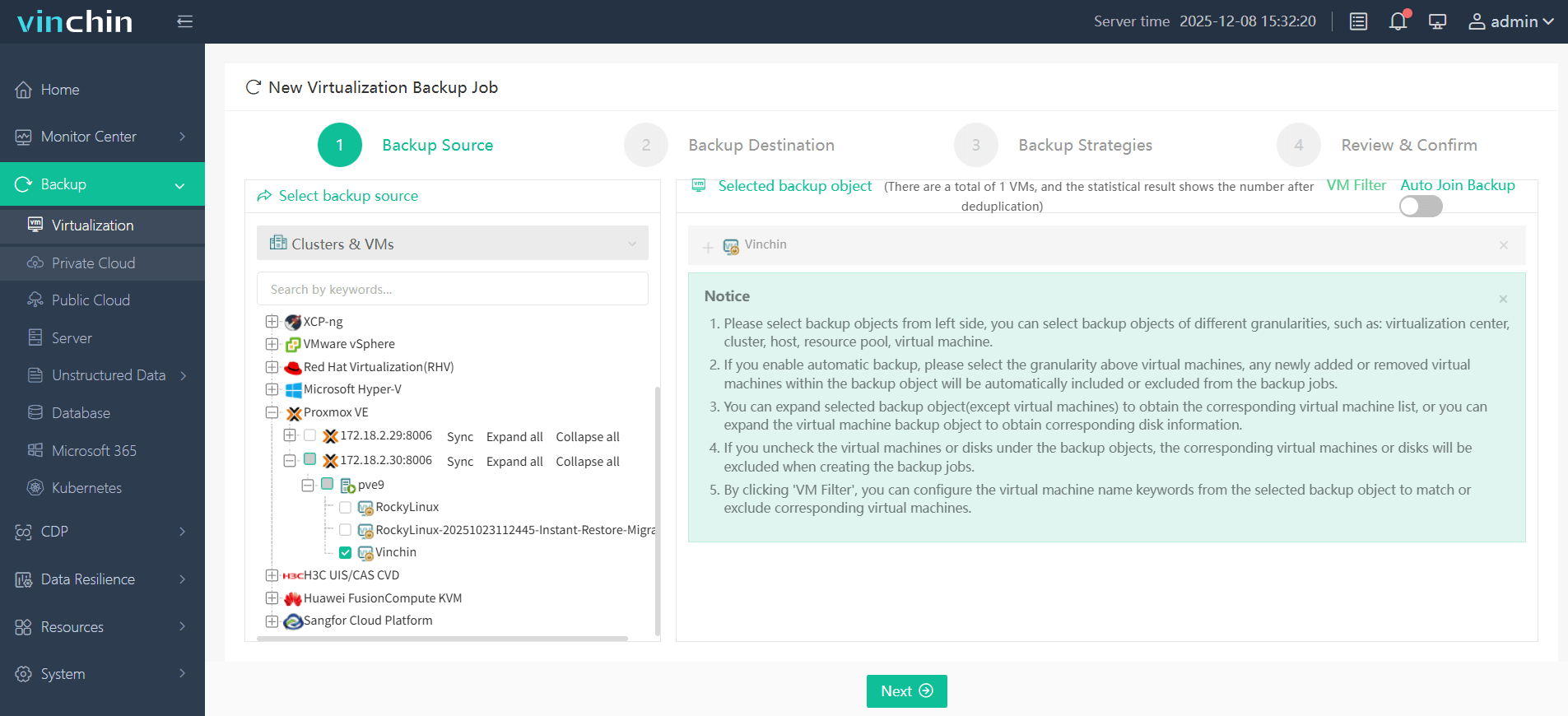

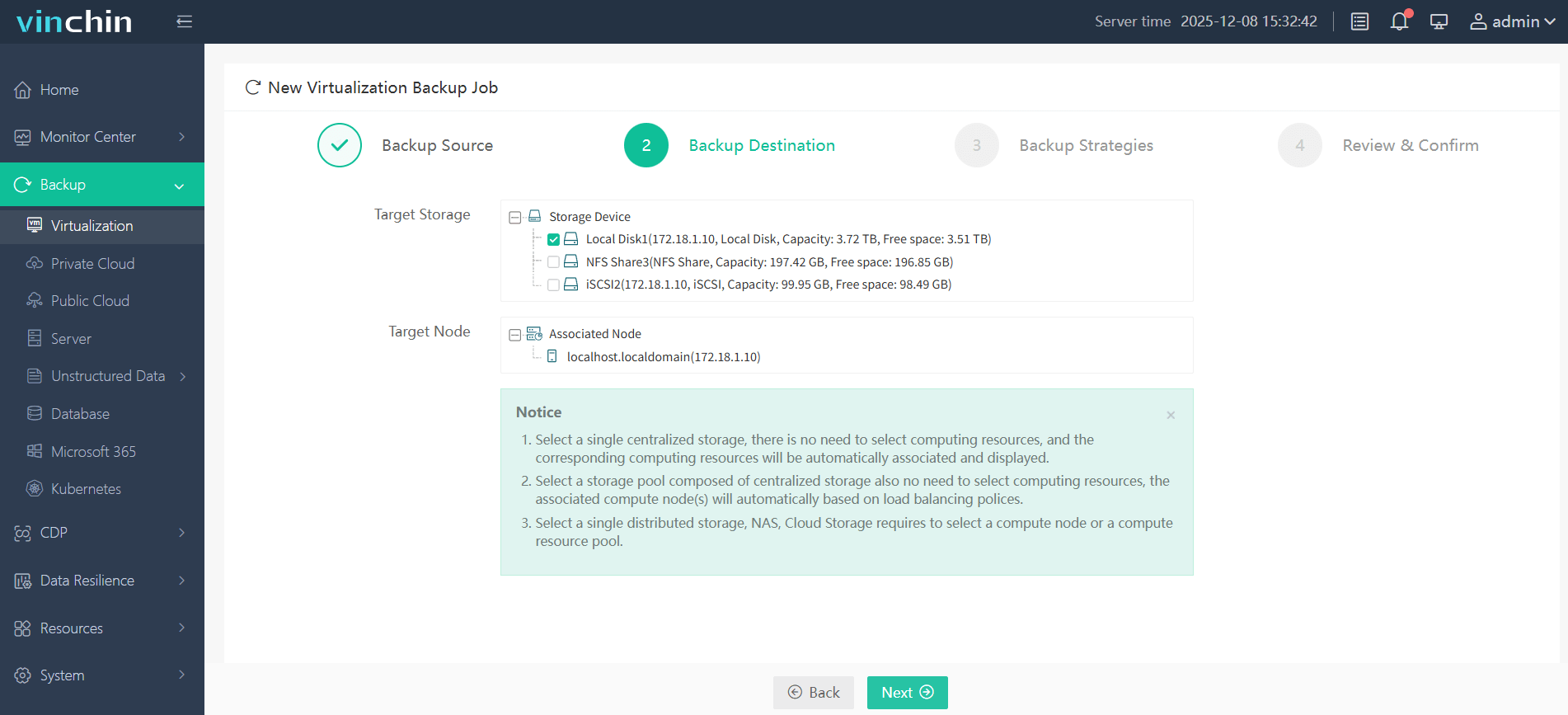

Die Webschnittstelle ist intuitiv. Sie können:

Wählen Sie die Proxmox-VM aus, die gesichert werden soll;

Danach Sicherungsspeicher wählen;

Weiter Sicherungsstrategien konfigurieren;

Übermitteln Sie schließlich den Auftrag, um die Sicherung zu starten.

Vinchin wird weltweit von Kunden mit Bestnoten empfohlen. Testen Sie eine 60-tägige, voll ausgestattete kostenlose Testversion und schützen Sie Proxmox-VMs ganz einfach. Klicken Sie auf Installer herunterladen, um zu beginnen.

Proxmox IO-Verzögerungs-Häufig gestellte Fragen

F1: Welches Maß an IO-Verzögerung ist für den täglichen Proxmox-Arbeitslasten sicher?

A1: Unter 5 % ist normal; gelegentliche Spitzen bis 10–15 % sind in Ordnung; dauerhaft über 20 % erfordert eine Überprüfung.

Q2: Wie kann ich überprüfen, welcher virtuelle Computer hohe E/A-Verzögerung verursacht?

A2: Verwenden Sie iotop, um eine hohe Datenträger-I/O zu erkennen, und beenden oder pausieren Sie anschließend die VM, um die Auswirkungen zu überprüfen.

F3: Können Sicherungsaufgaben eine E/A-Verzögerung verursachen, und wie kann diese minimiert werden?

A3: Ja; verwenden Sie inkrementelle oder fortlaufend inkrementelle Sicherungen und planen Sie Zeiträume mit geringer Auslastung ein, um die Belastung zu reduzieren.

Fazit

IO-Verzögerungen zeigen Speicherwartezeiten auf, die VMs verlangsamen können. Sie wissen nun, was IO-Verzögerung bedeutet, warum Werte unter 5 % ideal sind und wann Auffälligkeiten relevant sind. Sie haben gelernt, wie man die Hardware-Integrität prüft, die Ein-/Ausgabe mit Tools wie iostat und iotop überwacht, Speicherstapel von ZFS bis hin zu Netzwerkspeichern untersucht und Einstellungen auf Betriebssystem- und Proxmox-Ebene optimiert. Zu den erweiterten Maßnahmen gehören tiefergehende Analysen mit fio, Kapazitätsplanung und die Optimierung des Schedulers.

Sichern Sie VMs immer vor größeren Änderungen – die Lösung von Vinchin bietet eine dauerhafte inkrementelle Sicherung, Deduplizierung und mehr, um Daten sicher zu schützen. Probieren Sie die 60-tägige kostenlose Testversion von Vinchin aus, um Ihre Proxmox-Umgebung abzusichern.

Teilen auf: