-

Die Probleme durch doppelte Daten

-

Kategorien von Duplicaten in der Datensicherung

-

Was ist Deduplizierung?

-

Wie kann man feststellen, ob die Duplikaterkennung für die Daten effektiv ist?

-

Eine angemessene Sicherungsstrategie einrichten, um Duplikatdaten zu reduzieren

-

Welche Backup-Software ist die beste?

-

Backup Data Deduplication FAQs

-

Schlussfolgerung

Eine Datensicherung stellt sicher, dass ein Unternehmen im Falle eines Datenverlusts durch Hardwareausfälle, Naturkatastrophen, menschliche Fehler oder bösartige Angriffe schnell den Betrieb wieder aufnehmen kann, wodurch Ausfallzeiten und Verluste minimiert werden. Ein oft übersehenes, aber entscheidendes Problem im Datensicherungsprozess sind doppelte Daten. Doppelte Daten beziehen sich auf identische oder redundante Daten innerhalb des Backup-Sets. Dieses Problem kann entstehen, wenn dieselben Daten wiederholt gesichert werden, alte Versionen nach Updates nicht gelöscht werden oder die Sicherungsstrategien nicht richtig sind.

Die Probleme durch doppelte Daten

Doppelte Daten verbrauchen nicht nur wertvollen Speicherplatz und erhöhen die Speikosten, sondern können den Prozess der Datensicherung und Wiederherstellung auch komplexer und ineffizienter gestalten. Wenn ein Sicherungssatz eine große Menge an doppelten Daten enthält, muss jeder Sicherungsvorgang diesen überflüssigen Inhalt verarbeiten und übertragen, was Netzwerkkapazität verschwendet und die Sicherungszeit verlängert. Während der Datenwiederherstellung erhöhen doppelte Daten ebenfalls die Schwierigkeit und die benötigte Zeit, da das System durch die Dateien gehen und identifizieren muss, welche wirklich wiederhergestellt werden müssen.

Darüber hinaus kann doppelte Daten die Datenvorlieferung komplizieren. Ein großer Mengen doppelter Daten machen die Datenvorlieferung komplexer, erhöhen die Wartungsschwierigkeit und die Kosten. Zudem können doppelte Daten tatsächliche Änderungen der Daten verdecken und stören so die Datenanalyse.

Daher ist die Bewältigung des Problems doppelter Daten in Backups entscheidend. Durch die Anwendung effektiver Deduplizierungstechniken kann der Backup-Prozess optimiert werden, wodurch die Speicher- und Backup-Effizienz verbessert, die Kosten reduziert und die Datengenauigkeit sowie die Verwaltbarkeit gewährleistet werden.

Kategorien von Duplicaten in der Datensicherung

Dateibereichsduplikation: Die gesamte Datei wird mehrfach gesichert, wobei jede Sicherung eine vollständige Kopie der Datei ist. Dies tritt häufig bei Vollsicherungen von Ordnern oder ganzen Systemen auf.

Datenblöck-Duplikation: Datenblöcke innerhalb einer Datei werden redundant über mehrere Sicherungen gespeichert. Dies ist subtiler, kann aber zu erheblichem Speicherplatzverlust führen. Blöck-Duplikation erfordert normalerweise spezialisierte Deduplizierungstechnologie zur Erkennung und Beseitigung.

Versionsduplikation: Mehrere Versionen derselben Datei werden gespeichert, wobei jede Version kleine Unterschiede aufweist, aber größtenteils die gleichen Daten enthält.

Metadaten-Duplikation: Während des Backups können auch Dateimetadaten (z.B. Erstellungszeit, Änderungszeit) redundant gespeichert werden. Obwohl diese Daten relativ wenig Speicherplatz einnehmen, können sie bei umfassenden Backups erheblich anwachsen.

Was ist Deduplizierung?

Deduplizierungs-Technologie optimiert die Auslastung des Speicherplatzes indem sie duplierte Datenblöcke identifiziert und eliminiert.Dieser Prozess beruht darauf eindeutige digitale Signaturen (Fingerabdrücke) für jeden Datenblock zu erstellen und Hash-Speicher zur Erkennung von Duplikaten zu verwenden.Aufgrund der Implementationszeit lässt sich die Duplikatenerkennung in zwei Haupttypen einteilen: Inline (Online) und Nachverarbeitung (Offline). Die Inline-Deduplizierung wird angewendet, bevor die Daten auf die Speichermedien geschrieben werden, wobei nur eindeutige Datensegmente gespeichert werden, während die nachverarbeitende Deduplizierung die Daten nach der Schreibvorgangs optimiert.

Zusätzlich kann die Duplikatenerkennung basierend auf dem Ausführungsstandort in quellbasierte und zielbasierte Duplikatenerkennung unterteilt werden. Quellbasierte Deduplizierung verarbeitet Daten, bevor sie übertragen werden, was das Netzwerkübertragungsvolumen effektiv reduziert.

In der Vergangenheit war SIS (Single Instance Storage) eine Form von Deduplizierungstechnologie, die auf der Dateiebene arbeitete. Moderne Deduplizierungstechnologien arbeiten auf der Datenebene und bieten bessere Deduplizierungseffekte, aber mit höherer Implementierungskomplexität. Inkrementelle Backups können doppelte Backups bis zu einem gewissen Grad reduzieren, aber da sie auf der Dateiebene arbeiten, haben sie eine schlechte Granularität und die langfristige Verwendung inkrementeller Backups ist aufgrund der Komplexität des Wiederherstellungsprozesses nicht praktikabel.

Deduplizierungstechnologie ist nicht nur für Backup- und Archivierungssysteme geeignet, sondern kann auch auf Online-, Nahe-Zeit- und Offline-Datenspeichersysteme angewendet werden, einschließlich Dateisysteme, Volumenverwalter, NAS, SAN und andere Szenarien.

Wie kann man feststellen, ob die Duplikaterkennung für die Daten effektiv ist?

Die Effektivität der Duplikaterkennung hängt von mehreren Faktoren ab:

A. Datenänderung: Je weniger die Daten ändern, desto effektiver wird die Deduplizierung sein.

B. Kompressierbarkeit von Daten: Die Kompressionstechnologie wird in der Regel in Kombination mit der Duplikatentfernung eingesetzt. Daten mit hoher Kompressierbarkeit können die Bandbreite und das Speicherplatzbedarf erheblich reduzieren, auch wenn der Verhältnis der Duplikatentfernung nicht hoch ist.

C. Datenspeicherdauer: Je länger die Datenspeicherdauer, desto vorteilhafter wird die Duplikatenerkennung, da sie die Speicherplatzanforderungen erheblich reduzieren kann.

Eine angemessene Sicherungsstrategie einrichten, um Duplikatdaten zu reduzieren

Zur Einrichtung einer angemessenen Sicherungsstrategie, um Duplikatdaten zu reduzieren, können folgende Maßnahmen ergriffen werden:

1. Voll- und Inkrementelle Sicherungen kombinieren: Zuerst oder nach wichtigen Datenaktualisierungen vollständige Sicherungen durchführen, um ein vollständiges Datensnapshot zu erstellen; tägliche inkrementelle Sicherungen durchführen, um neue Änderungen festzuhalten, wodurch doppelte Daten reduziert und Ressourcen eingespart werden.

2. Archivierungs- und Reinigungsrichtlinien umsetzen: Regelmäßige Archivierungspläne einrichten, um selten genutzte aber notwendige Daten in kostengünstige Speicher zu verschieben; identifizieren und bereinigen redundante oder veraltete Daten, Datenerhaltungsfristen festlegen und den Reinigungsprozess automatisieren.

3. Optimieren des Sicherungsprozesses: Wählen Sie Sicherungssoftware, die Deduplizierung unterstützt, die automatisch duplizierte Daten während der Sicherung entfernt; komprimieren und verschlüsseln Sie archivierte Daten, um Platz zu sparen und die Sicherheit weiterhin zu verbessern.

4. Ständige Überwachung und Anpassung der Strategie: Überprüfen Sie regelmäßig die Effektivität der Datensicherungen, überwachen Sie die Speichernutzung und passen Sie die Sicherungs- und Archivierungsstrategien nach Bedarf angeschlossen an geschäftliche Veränderungen an, um eine effiziente Betriebsführung und die Einhaltung von Vorschriften zu gewährleisten.

Welche Backup-Software ist die beste?

Vinchin Backup & Recovery ist eine professionelle Virtualisierungs-Backup-Software, die über 10 Virtualisierungsplattformen unterstützt, einschließlich VMware, Hyper-V, Proxmox, XenServer und oVirt usw. Sie bietet hervorragende Funktionen für das Backup und die Wiederherstellung von virtuellen Maschinen und ermöglicht auch cross-plattform Migration.

Natürlich umfasst Vinchin Backup & Recovery auch Duplikationsvermeidungs- und Kompressionsfunktionen. Es bietet eine anpassbare Blockgrößen-Duplikationsvermeidungsfunktion, die gegenüber traditionellen festen Duplikationsvermeidungen vorteilhafter ist und den Platz für Backups effektiv reduziert.

Durch die Anwendung der Deduplikationstechnologie und Kompression von Vinchin können Sie die Geschwindigkeit während des Backup-Speicherprozesses verbessern und die von Backup-Daten belegten Speicherkapazitäten reduzieren. Gleichzeitig wird das Risiko einer globalen Datencorruption, das durch globale Deduplikation verursacht werden kann, beseitigt.

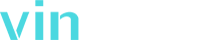

Um die Duplikatenerkennung während des Backups zu aktivieren, führen Sie einfach diese Schritte aus:

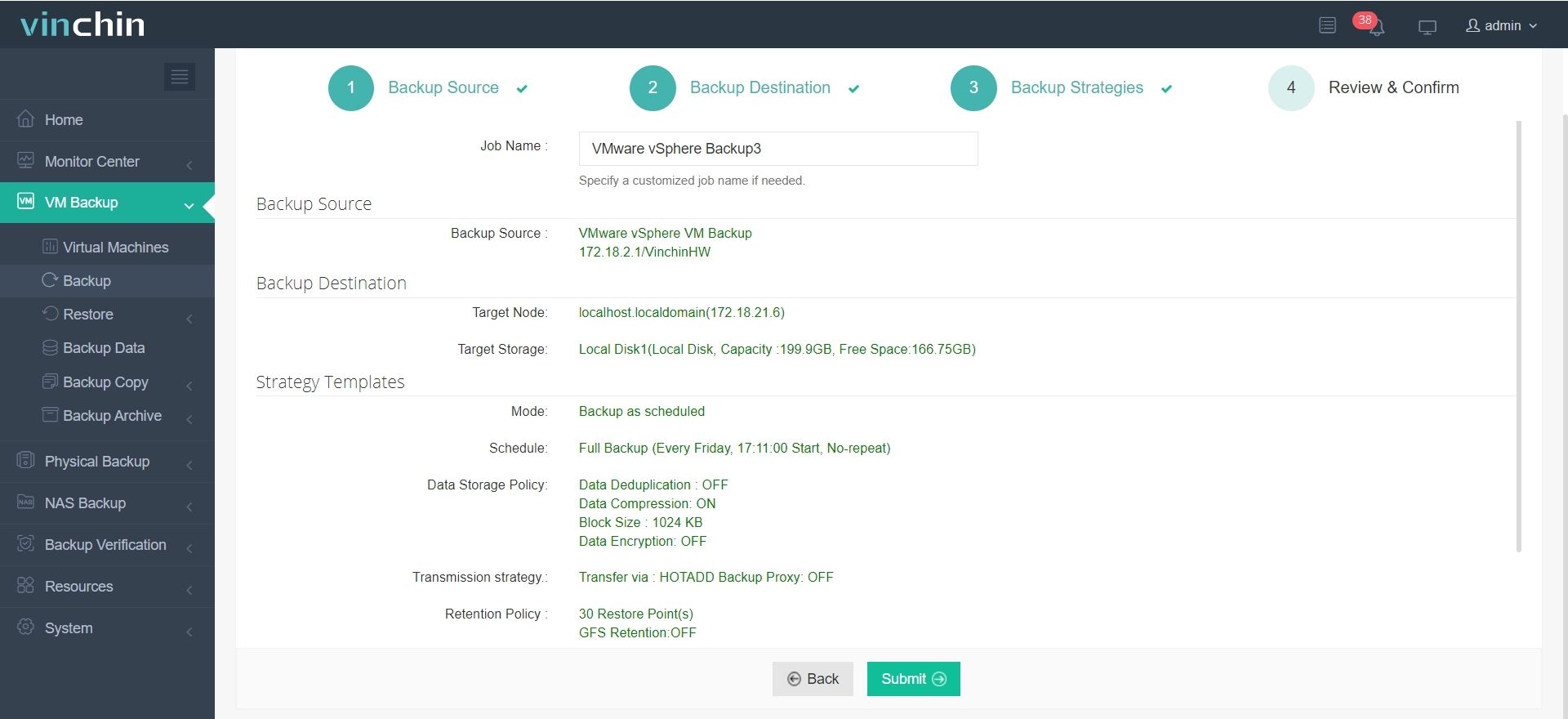

1. Wählen Sie die virtuelle Maschine aus, die Sie sichern möchten.

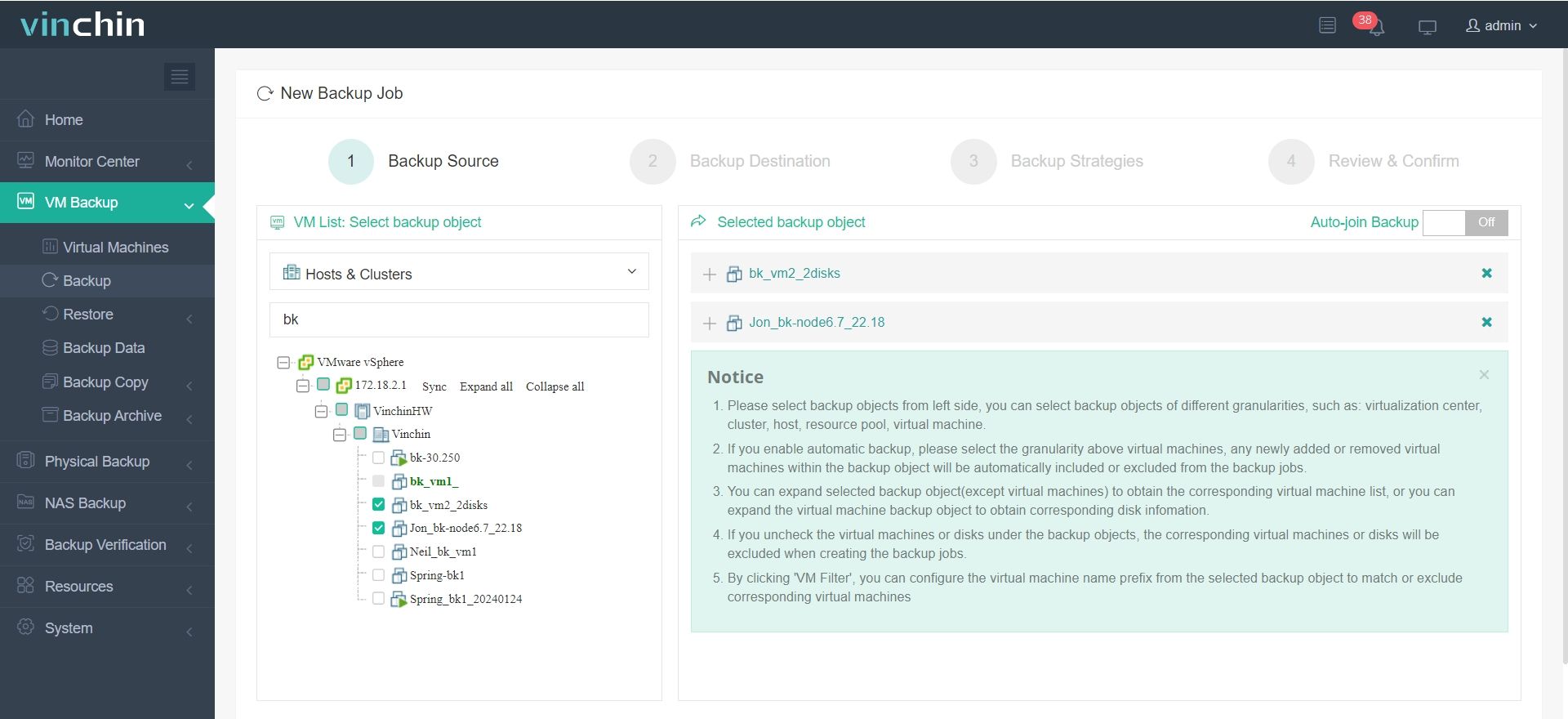

2. Wählen Sie das Ziel für die Datensicherung aus.

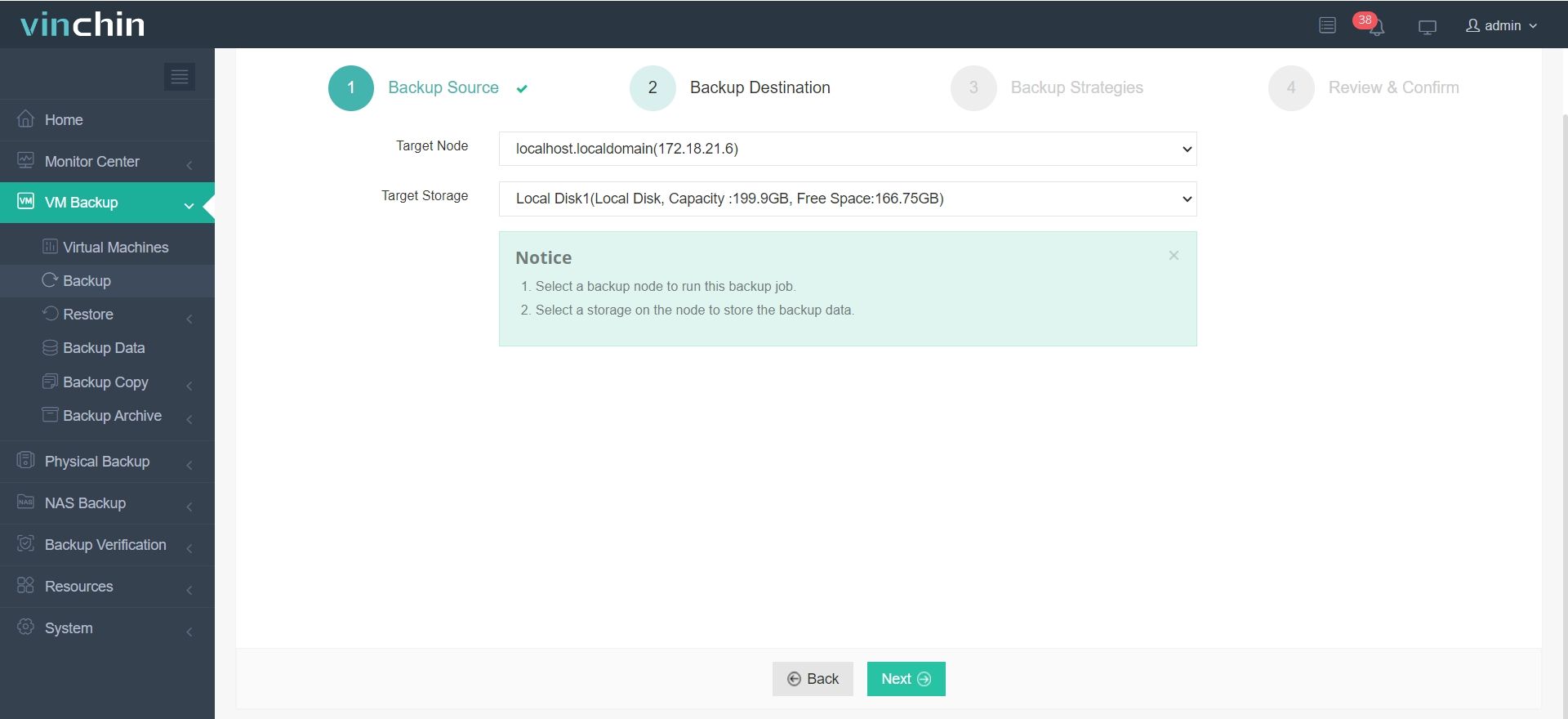

3. Konfigurieren Sie die Backup-Strategien.

Im Abschnitt "Datenverwaltungsrichtlinie" können Sie festlegen, ob Duplikatvermeidung und Komprimierung aktiviert werden sollen.

4. Bestätigen Sie das Backup-Job.

Neben den genannten Funktionen bietet Vinchin viele weitere fortgeschrittene Funktionen, die darauf warten, von Ihnen entdeckt zu werden. Klicken Sie auf den untenstehenden Button, um eine 60-tägige kostenlose Testversion mit voller Funktionalität zu starten!

Backup Data Deduplication FAQs

1. Frage: Welche Art von Daten eignet sich für die Deduplikation und welche nicht?

A: Die Duplikatenerkennung und -beseitigung ist für jeden Datentyp geeignet, einschließlich Office-Dokumente, Datenbanken, Multimediadateien und virtueller Maschinen. Obwohl einige Daten aufgrund ihrer Natur bei der ersten Sicherung möglicherweise keine signifikanten Effekte der Duplikatenerkennung und -beseitigung zeigen, werden die Vorteile bei nachfolgenden Sicherungen offensichtlich. Je häufiger Sicherungen durchgeführt werden und je kürzer der Zeitraum zwischen ihnen ist, destörfiger ist das Verhältnis der Duplikatenerkennung und -beseitigung.

2. Frage: Was ist feste Blocklängen-Deduplizierung und was ist variable Blocklängen-Deduplizierung?

A: Die Deduplizierung mit festen Blocklängen teilt Daten in feste Blockgrößen auf und identifiziert Duplikate durch den Vergleich des Inhalts jedes Blocks. Diese Methode ist einfach, kann aber Gelegenheiten verpassen, Redundanzen zu beseitigen, wenn identische Daten leicht versetzt sind. Die Deduplizierung mit variablen Blocklängen hingegen teilt Daten basierend auf Inhaltsmustern in Blöcke unterschiedlicher Größe auf, was eine präzisere Erkennung von Duplikaten auch bei Verschiebungen der Daten ermöglicht. Dadurch ist die Deduplizierung mit variablen Blocklängen effizienter bei der Reduzierung des Speichers, obwohl sie komplexer in der Umsetzung ist.

Schlussfolgerung

Duplizierte Daten verschwenden nicht nur Speicherplatz, erhöhen die Betriebskosten für Unternehmen, sondern können auch die Effizienz von Datensicherungen und -wiederherstellungen beeinträchtigen und die Datenverwaltung komplizieren. Daher ist die Verwendung effektiver Deduplizierungstechnologien, um duplizierte Daten zu reduzieren, entscheidend. Durch Deduplizierung können Unternehmen den Speicherausbau optimieren, Kosten senken und die Effizienz sowie die Genauigkeit der Datenverwaltung verbessern.

Teilen auf: