-

Was ist ein Rechenzentrum?

-

Warum ist eine Katastrophenwiederherstellung für Rechenzentren notwendig?

-

Datacenter-Desasterwiederherstellung: Best Practices

-

Gängige Datacenter-Desaster-Recovery-Architekturen

-

Grundsätze für Lösungen zur Wiederherstellung von Rechenzentren

-

Datenschutz mit Vinchin-Lösung verbessern

-

Datacenter-Desasterwiederherstellung Häufig gestellte Fragen

-

Schlussfolgerung

Mit der Entwicklung der Technologie verlassen sich Unternehmen zunehmend auf die Datenverarbeitung für ihre täglichen Operationen, wodurch ihre Geschäftskontinuität stark von der Stabilität des Rechenzentrums abhängt. Allerdings könnten Rechenzentren in einer Umgebung mit Risiken und Bedrohungen betrieben werden. Falls diese Risiken nicht effektiv gesteuert werden können, könnte der Verlust von Daten erhebliche Auswirkungen auf die tägliche Arbeit der Unternehmen haben. Wenn die Kern-Daten verloren gehen, können einige Kernfunktionen lahmgelegt werden, was zu unersetzlichen Verlusten führt. Daher ist es für Unternehmen unverzichtbar, bei der Errichtung von Rechenzentren die Geschäftskontinuität sowie die hohe Zuverlässigkeit und Verfügbarkeit der Daten sicherzustellen.

Was ist ein Rechenzentrum?

Ein Rechenzentrum ist eine dedizierte physische Einrichtung oder eine Gruppe von Einrichtungen, die entwickelt wurden, um zentral die kritische IT-Infrastruktur eines Unternehmens zu speichern, zu verwalten und zu betreiben. Dazu gehören unter anderem Computerserver, Speichersysteme, Netzwerkausrüstung, Sicherheitsgeräte und verwandte unterstützende Komponenten. Die Hauptfunktion eines Rechenzentrums besteht darin, große Mengen an Daten sowie verschiedene Geschäftsanwendungen effizient und zuverlässig zu verarbeiten, zu speichern, zu übertragen, auszutauschen und zu verwalten sowie leistungsstarke Rechenkapazitäten und Datenverarbeitungsplattformen für den internen Betrieb, externe Dienste und Cloud-Computing-Anforderungen des Unternehmens bereitzustellen.

Warum ist eine Katastrophenwiederherstellung für Rechenzentren notwendig?

1. Geschäftskontinuität: Katastrophen, sei es Naturkatastrophen (z. B. Erdbeben, Überschwemmungen, Hurrikans) oder menschliches Versagen (z. B. Brände, Cyberangriffe, Geräteausfälle), können die Operationen in einem Rechenzentrum stark stören oder sogar ganz zum Erliegen bringen. Ein zuverlässiger Katastrophenwiederherstellungsplan ermöglicht es einem Unternehmen, geschäftskritische Anwendungen, Dienste und Systeme schnell wiederherzustellen und sicherzustellen, dass wesentliche Geschäftsfunktionen mit minimaler Unterbrechung fortgeführt werden können. Dies hilft, Einnahmeströme aufrechtzuerhalten, die Kundenzufriedenheit zu sichern und die allgemeine Wettbewerbsfähigkeit zu bewahren.

2. Minimierung von Ausfallzeiten: Stromausfälle im Rechenzentrum können erhebliche finanzielle Verluste verursachen, die durch verlorene Produktivität, verpasste Transaktionen, Schäden am Ruf und potenzielle rechtliche Haftungen entstehen. Strategien zur Katastrophenwiederherstellung und regelmäßige Datensicherungen ermöglichen es Unternehmen, sich schnell von Störungen zu erholen und die Dauer von Ausfallzeiten zu minimieren. Je schneller die Wiederherstellung erfolgt, desto geringer ist die Auswirkung auf das Unternehmen und seine Stakeholder.

3. Einhaltung gesetzlicher Vorschriften: Viele Branchen unterliegen strengen Vorschriften zum Schutz von Daten, Privatsphäre und Verfügbarkeit. Beispiele hierfür sind das HIPAA-Gesetz im Gesundheitswesen, die DSGVO (Datenschutz-Grundverordnung) in der Europäischen Union und der Sarbanes-Oxley Act (SOX) für öffentliche Unternehmen. Solche Vorschriften schreiben oft vor, dass Organisationen umfassende Notfallwiederherstellungspläne haben müssen, um die Vertraulichkeit, Integrität und Verfügbarkeit sensibler Informationen sicherzustellen.

4. Reduzierung einzelner Ausfallpunkte: Die Konzentration aller IT-Operationen in einem einzigen Rechenzentrum schafft einen einzelnen Ausfallpunkt. Sollte diese Einrichtung nicht mehr verfügbar sein, sind es auch die davon abhängigen Dienste und Daten. Bei der Katastrophenwiederherstellung werden sekundäre Standorte eingerichtet, entweder physisch weit entfernt oder unter Verwendung cloudbasierter Lösungen, um das Risiko zu verteilen und alternative Standorte für die Wiederaufnahme der Dienste bereitzustellen. Diese geografische Redundanz erhöht die gesamte Widerstandsfähigkeit und verringert die Wahrscheinlichkeit, dass ein einzelnes Ereignis die gesamte IT-Infrastruktur gefährdet.

Datacenter-Desasterwiederherstellung: Best Practices

Die Technologien zur Wiederherstellung nach Katastrophen für Rechenzentren lassen sich im Allgemeinen in fünf Typen unterteilen: Cold Backup, Warm Backup, Hot Backup, Active-Active und Multi-Active.

Kaltbackup: Auch als Offline-Backup bekannt, bezeichnet das Kaltbackup eine vollständige Sicherung der Datenbank, die durchgeführt wird, wenn die Datenbank heruntergefahren und nicht aktualisierbar ist. Beim Kaltbackup übernimmt nur das primäre Rechenzentrum die Geschäftsaufgaben, während das sekundäre Rechenzentrum kein Echtzeit-Backup des primären Rechenzentrums durchführt. Wenn das primäre Rechenzentrum ausfällt, kommt es zu Geschäftsausfällen. Diese Technologie verfügt nicht über fortschrittliche Fähigkeiten zur Fehlvermeidung und Übernahme, was zu einer langen RTO (Recovery Time Objective) führt und daher für die hohen Anforderungen der modernen Rechenzentrum-Notfallwiederherstellung ungeeignet ist.

Warm-Backup: Warm-Backup ist eine Methode zwischen Cold- und Hot-Backup. Sie umfasst hauptsächlich das Einrichten von entfernter Datenspiegelung, Datenbankreplikation und den Aufbau eines Rechenzentrums für die Wiederherstellung, um eine vollständige Sicherung des gesamten Systems zu erreichen.

Hot Backup: Auch als dynamische Sicherung bekannt, bezeichnet die Online-Sicherung zwischen zwei Servern in einem Hochverfügbarkeitssystem. Obwohl das Hot Backup nur eine Echtzeitsicherung des primären Rechenzentrums durchführt, kann das sekundäre Rechenzentrum bei einem Ausfall des primären Rechenzentrums und der damit verbundenen Geschäftsunterbrechung automatisch die Geschäftsprozesse des primären Rechenzentrums übernehmen und gewährleisten, dass die Geschäftstätigkeit möglichst schnell wiederhergestellt wird.

Active-Active: Dies ist eine ressourceneffiziente Lösung für die Katastrophenwiederherstellung von Rechenzentren. In diesem Szenario übernehmen beide Rechenzentren – das primäre und das sekundäre – gleichzeitig Geschäftsverkehr und bieten Dienste nach außen. Sowohl das primäre als auch das sekundäre Rechenzentrum fungieren gegenseitig als Backup und führen Echtzeit-Backups durch. In der Regel übernimmt das primäre Rechenzentrum eine höhere Last, beispielsweise 60-70% des Geschäftsverkehrs. Im Vergleich zu Hot- und Cold-Backups ermöglicht die Active-Active-Technologie, dass sowohl das primäre als auch das sekundäre Rechenzentrum zeitgleich Geschäftsverkehr abwickeln. Wenn ein Rechenzentrum ausfällt, übernimmt das andere Rechenzentrum automatisch alle Geschäftsvorgänge und stellt somit einen kontinuierlichen Betrieb sicher.

Multi-Active: Multi-Active bezieht sich im Allgemeinen darauf, unabhängige Rechenzentren in verschiedenen Städten einzurichten. „Aktiv“ steht dabei im Gegensatz zu Cold Backup. Bei einem Cold Backup werden zwar alle Daten gesichert, es unterstützt aber während des normalen Betriebs keine Geschäftsanforderungen. Ein Wechsel zum sekundären Rechenzentrum erfolgt hier erst, wenn das primäre Rechenzentrum ausfällt. Bei Multi-Active hingegen bedeutet dies, dass diese Rechenzentren im regulären Betrieb ebenfalls Datenverkehr bewältigen und die Geschäftsvorgänge unterstützen.

Gängige Datacenter-Desaster-Recovery-Architekturen

1. Aufbau eines entfernten Disaster-Recovery-Zentrums mithilfe der Cloud: Das lokale physische Rechenzentrum fungiert als primäres Rechenzentrum, und nur Daten werden in die Cloud gesichert.

2. Wiederherstellung nach Katastrophen in derselben Region basierend auf Public Cloud: Das gesamte System in die Cloud migrieren und in zwei verschiedenen Availability Zones innerhalb derselben Region bereitstellen.

3. Katastrophenwiederherstellung über Regionsgrenzen hinweg basierend auf der Public Cloud: Migrieren Sie das gesamte System in die Cloud und stellen Sie es in zwei verschiedenen Regionen bereit, um eine Katastrophenwiederherstellung über Regionsgrenzen hinweg zu ermöglichen.

4. Kombination von lokalen und überregionalen Desaster-Recovery-Systemen: Beispiele hierfür sind zwei Standorte mit drei Rechenzentren oder drei Standorte mit fünf Rechenzentren.

Grundsätze für Lösungen zur Wiederherstellung von Rechenzentren

1. Bei der Erstellung eines Notfallwiederherstellungsplans müssen die Auswirkungen bei der Errichtung eines Notfallwiederherstellungssystems auf die bestehenden Geschäftssysteme berücksichtigt werden. Beispielsweise die durch die Verwendung von Datenreplikationstechnologien verursachte Latenz bei der System-I/O und der Druck auf die täglichen Geschäftssysteme durch die Anwendung von Datensynchronisation.

2. Die Datenstände müssen synchronisiert bleiben, um bei einer Katastrophe einen erfolgreichen Wechsel zu den Sicherungszentren zu gewährleisten.

3. Die tägliche Wartung der Notfallwiederherstellungssysteme sollte so gering wie möglich sein und in der Lage sein, einige Geschäftsverarbeitungs- und Testaufgaben zu bewältigen.

4. Die RTO sollte so kurz wie möglich sein.

5. Teilschaltung und Fallback von Geschäftssubsystemen sollten realisierbar sein.

6. Bei der Auswahl technischer Lösungen sind die Grundsätze der Reife, Stabilität, hohen Zuverlässigkeit, Skalierbarkeit und Transparenz zu beachten.

7. Bei der Erstellung von Systemlösungen können mehrere Technologiekombinationen gewählt werden.

Datenschutz mit Vinchin-Lösung verbessern

Vinchin Backup & Recovery ist eine professionelle Lösung, die zum Schutz von Daten und zur Wiederherstellung nach Katastrophen in virtualisierten Umgebungen entwickelt wurde. Sie unterstützt verschiedene virtuelle Plattformen wie VMware, Hyper-V, XenServer, Proxmox, XCP-ng usw. sowie Datenbanken, NAS, Dateiserver, Linux- und Windows-Server usw. Mit maßgeschneiderten Funktionen für virtuelle Umgebungen bietet Vinchin automatische Backups, agentenlose Backups, LAN-/LAN-freie Optionen, Offsite-Kopie, sofortige Wiederherstellung, Datendeduplizierung und Cloud-Archivierung. Zudem bietet sie Datenverschlüsselung und Schutz gegen Ransomware.

Mit der funktionierten Backup-Funktion ermöglicht es eine schnelle Integration von virtuellen Maschinen in das Backup-System. Es bietet Funktionen zur Katastrophenwiederherstellung wie Instant Restore, um virtuelle Maschinen innerhalb von Sekunden aus Backups neu zu starten, Offsite-Kopie für die remote Speicherung von Backups und automatische Backup-Überprüfung für Integritätschecks. Darüber hinaus unterstützt es V2V-Migration für nahtlose Übergänge in virtuelle Umgebungen.

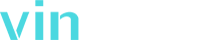

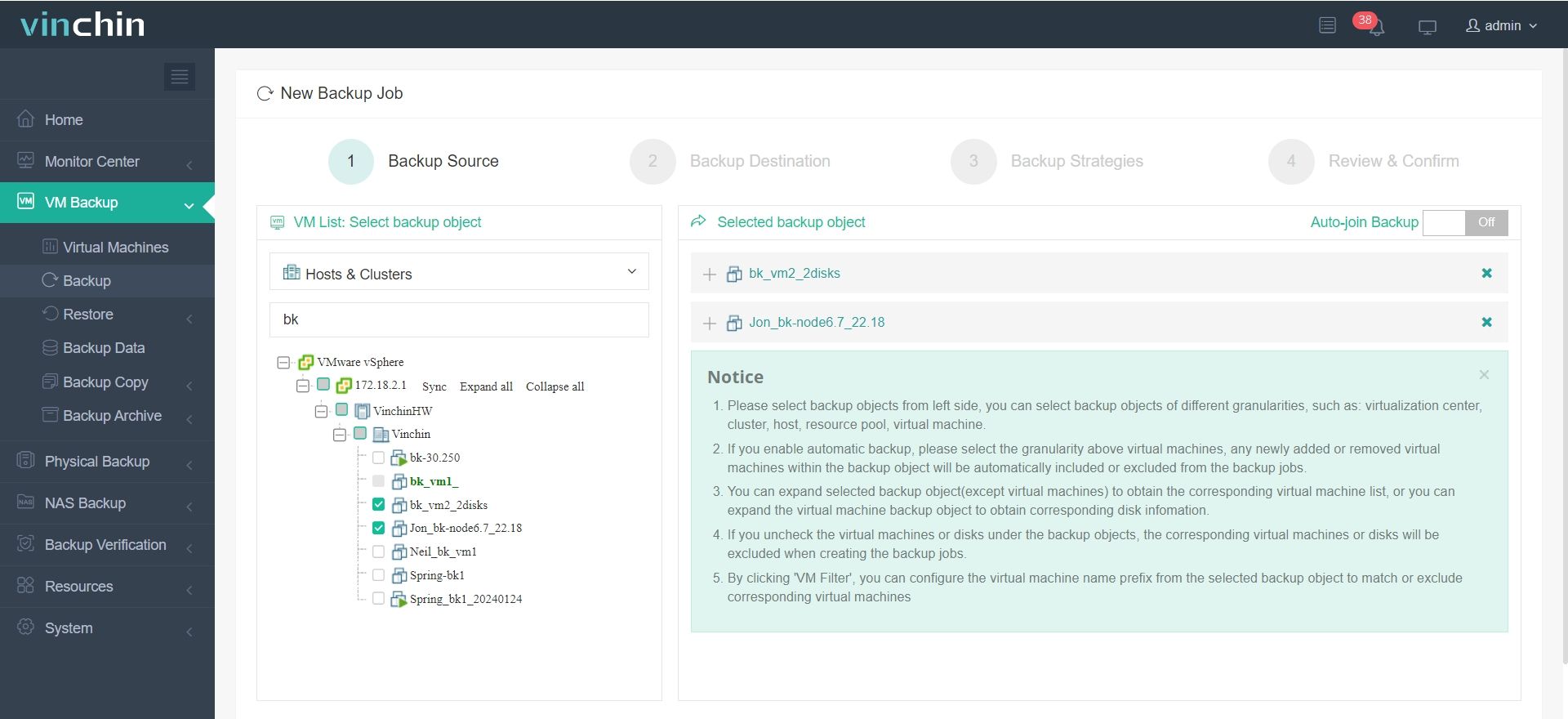

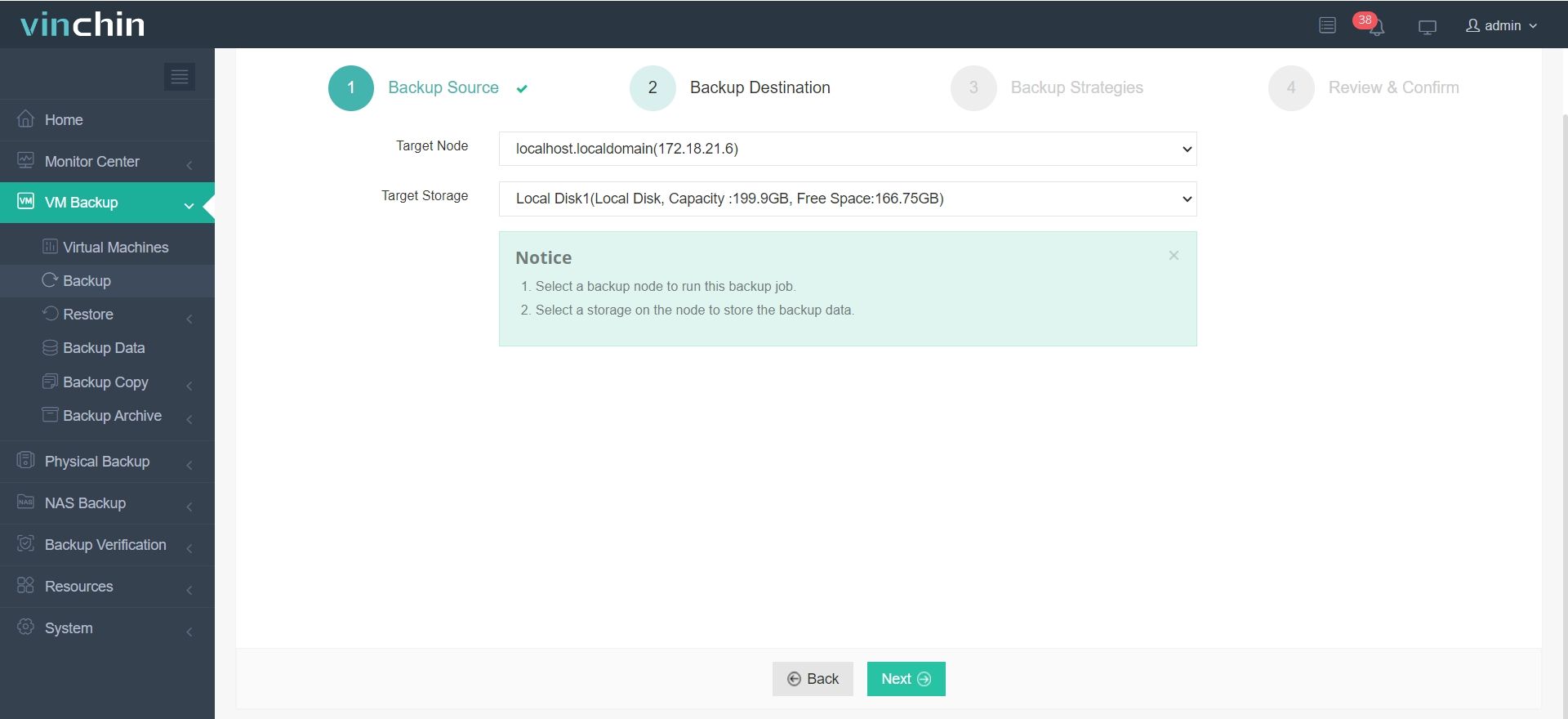

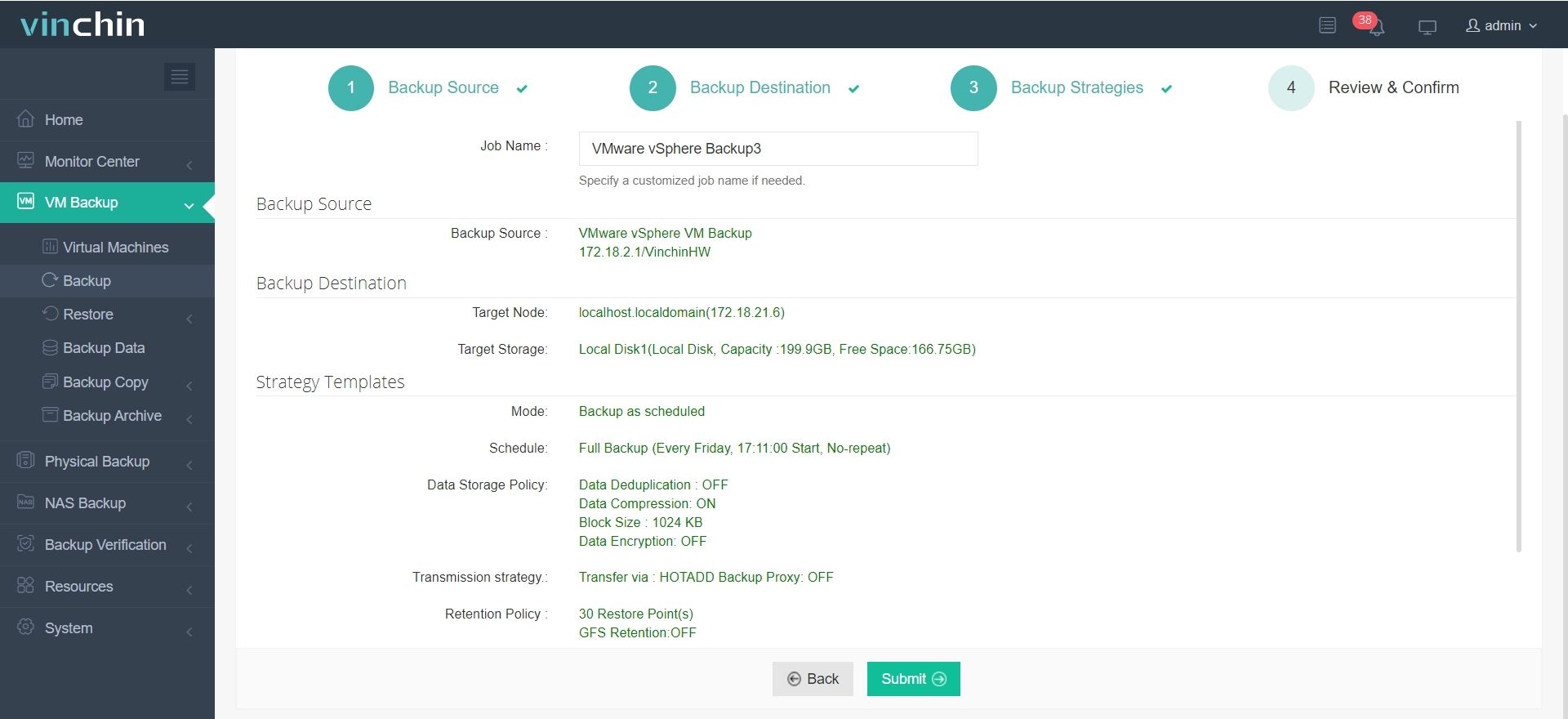

Es dauert nur 4 Schritte, um Ihre virtuelle Maschine mit Vinchin Backup & Recovery zu sichern:

1. Wählen Sie das Sicherungsobjekt aus.

2. Sicherungsziel auswählen.

3. Wählen Sie Backup-Strategien aus.

4. Prüfen und Auftrag senden.

Erleben Sie die Kraft dieses umfassenden Systems hautnah mit einer kostenlosen 60-Tage-Testversion! Hinterlassen Sie Ihre spezifischen Anforderungen, und Sie erhalten eine maßgeschneiderte Lösung, die perfekt zu Ihrer IT-Umgebung passt.

Datacenter-Desasterwiederherstellung Häufig gestellte Fragen

1. Frage: Was ist der Unterschied zwischen Desasterwiederherstellung und hoher Verfügbarkeit?

A: Der Hauptunterschied zwischen Katastrophenwiederherstellung und hoher Verfügbarkeit besteht darin, dass die Katastrophenwiederherstellung der Prozess ist, um nach einer schwerwiegenden Störung die Betriebsaktivitäten wieder aufzunehmen, während hohe Verfügbarkeit unter normalen Umständen einen kontinuierlichen Betrieb mit minimalem Ausfallzeit sicherstellt.

2. Frage: Welche Rolle spielt Virtualisierung bei der Wiederherstellung von Rechenzentren nach Katastrophen?

A: Virtualisierung bei der Wiederherstellung von Rechenzentren nach einer Katastrophe ermöglicht die Abstraktion von Servern, Anwendungen und Daten aus der physischen Hardware, wodurch die schnelle Wiederherstellung durch einfache Replikation, Migration und Failover von Workloads erleichtert wird.

Schlussfolgerung

Ein solider Katastrophenwiederherstellungsplan für ein Rechenzentrum ist entscheidend für die Aufrechterhaltung der Geschäftstätigkeit. Durch die Kombination verschiedener Technologien und Architekturen sowie die Priorität von Synchronisation und geringstem Wartungsaufwand können Organisationen Zuverlässigkeit und Widerstandsfähigkeit gewährleisten. Die Einhaltung der Prinzipien Stabilität, Skalierbarkeit und Transparenz ist von großer Bedeutung, um Risiken zu verringern und einen nahtlosen Betrieb während Störungen aufrechtzuerhalten.

Teilen auf: