-

Problemy związane z danymi zduplikowanymi

-

Kategorie zduplikowanych danych w kopii zapasowej

-

Czym jest usuwanie duplikatów?

-

Jak sprawdzić, czy usunięcie duplikatów jest skuteczne dla danych?

-

Tworzenie racjonalnej strategii tworzenia kopii zapasowych w celu zmniejszenia duplikacji danych

-

Które oprogramowanie do tworzenia kopii zapasowych jest najlepsze?

-

Kompresja danych w procesie tworzenia kopii zapasowych — Często zadawane pytania

-

Podsumowanie

Kopia zapasowa danych gwarantuje, że w przypadku utraty danych spowodowanej awarią sprzętu, katastrofą naturalną, błędem ludzkim lub atakiem złośliwego oprogramowania, przedsiębiorstwo będzie w stanie szybko przywrócić działalność, minimalizując przestoje i straty. Jednym często pomijanym, lecz kluczowym problemem w procesie tworzenia kopii zapasowych danych jest duplikacja danych. Dane duplikowane to identyczne lub zbędne dane znajdujące się w zestawie kopii zapasowej. Problem ten może wynikać z wielokrotnego tworzenia kopii tych samych danych, nieusuwanie starych wersji po aktualizacjach lub niewłaściwej strategii tworzenia kopii zapasowych.

Problemy związane z danymi zduplikowanymi

Dane zduplikowane nie tylko zużywają cenną przestrzeń dyskową i zwiększają koszty przechowywania, ale także mogą utrudnić i wydłużyć proces tworzenia kopii zapasowych i odzyskiwania danych. Gdy zestaw kopii zapasowej zawiera dużą ilość zduplikowanych danych, każda operacja tworzenia kopii musi przetwarzać i przesyłać te zbędne treści, co marnuje zasoby sieciowe i wydłuża czas tworzenia kopii zapasowej. Podczas odzyskiwania danych, duplikaty również zwiększają trudność i czas potrzebny na ich przywrócenie, ponieważ system musi filtrować i identyfikować pliki, które faktycznie wymagają odzyskania.

Ponadto dane duplikaty mogą utrudniać zarządzanie danymi. Duża ilość zduplikowanych danych czyni zarządzanie nimi bardziej skomplikowanym, zwiększając trudności i koszty utrzymaniowe. Co więcej, dane duplikaty mogą zasłaniać rzeczywiste zmiany w danych, utrudniając analizę danych.

Dlatego ważne jest rozwiązywanie problemu zduplikowanych danych w kopii zapasowej. Stosując skuteczne techniki usuwania duplikatów, można zoptymalizować proces tworzenia kopii zapasowych, poprawić efektywność przechowywania i tworzenia kopii zapasowych, zmniejszyć koszty oraz zapewnić dokładność i łatwość zarządzania danymi.

Kategorie zduplikowanych danych w kopii zapasowej

Duplikacja na poziomie plików: Cały plik jest kopiony wielokrotnie, przy czym każda kopia zapasowa jest pełnym egzemplarzem pliku. Jest to powszechne w pełnych kopii zapasowych folderów lub całych systemów.

Duplikacja na poziomie bloków danych: Bloki danych wewnątrz pliku są zapisywane w sposób nadmiarowy w wielu kopii zapasowych. Jest to bardziej subtelne, ale może prowadzić do znacznego marnotrawstwa miejsca na dysku. Duplikacja na poziomie bloków zazwyczaj wymaga specjalistycznej technologii usuwania duplikatów w celu wykrycia i eliminacji.

Duplikacja wersji: Zapisywane są wielokrotne wersje tego samego pliku, przy czym każda wersja zawiera drobne różnice, ale w dużej mierze te same dane.

Duplikacja metadanych: Podczas tworzenia kopii zapasowej metadane pliku (np. czas utworzenia, czas modyfikacji) mogą być również zapisywane w sposób nadmiarowy. Mimo że dane te zajmują stosunkowo mało miejsca, w przypadku dużych kopii zapasowych mogą się znacząco sumować.

Czym jest usuwanie duplikatów?

Technologia usuwania duplikatów optymalizuje wykorzystanie przestrzeni dyskowej, identyfikując i eliminując zduplikowane bloki danych.Proces ten polega na tworzeniu unikalnych podpisów cyfrowych (odcisków palców) dla każdego bloku danych i wykorzystywaniu magazynowania skrótów do wykrywania zduplikowanych danych.W zależności od momentu wdrożenia, usuwanie duplikatów można podzielić na dwa główne typy: inline (online) i post-process (offline).Deduplikacja inline jest stosowana przed zapisaniem danych do pamięci masowej, zapisując tylko unikalne segmenty danych, podczas gdy deduplikacja typu post-process optymalizuje dane po ich zapisaniu.Ponadto, w zależności od miejsca wykonania, usuwanie duplikatów można podzielić na deduplikację opartą na źródle i deduplikację opartą na celu.Źródłowa deduplikacja przetwarza dane przed ich transmisją, skutecznie zmniejszając wolumen transmisji sieciowej.

W przeszłości SIS (Single Instance Storage) był formą technologii eliminacji duplikatów działającej na poziomie plików. Współczesna technologia eliminacji duplikatów działa na poziomie bloków danych, oferując lepsze efekty eliminacji duplikatów, lecz wiązując się z większą złożonością implementacji. Tworzenie kopii zapasowych przyrostowych może w pewnym stopniu zmniejszyć ilość duplikatów, jednak ponieważ operują one na poziomie plików, mają niską szczegółowość, a długotrwałe stosowanie kopii zapasowych przyrostowych jest niewydajne ze względu na skomplikowany proces przywracania danych.

Technologia usuwania duplikatów nie jest odpowiednia wyłącznie dla systemów tworzenia kopii zapasowych i archiwizacji, ale może być również stosowana w systemach online, nearline i offline do przechowywania danych, w tym w systemach plików, menedżerach wolumenów, NAS, SAN i innych scenariuszach.

Jak sprawdzić, czy usunięcie duplikatów jest skuteczne dla danych?

Skuteczność usuwania duplikatów zależy od kilku czynników:

A. Ilość zmian danych: Im mniej dane ulegają zmianie, tym bardziej skuteczne będzie usuwanie duplikatów.

B. Kompresja danych: Technologia kompresji jest zazwyczaj stosowana razem z usuwaniem duplikatów. Dane o dużej skompresowalności mogą znacznie zmniejszyć zużycie pasma sieciowego i miejsca na dysku nawet wtedy, gdy współczynnik usuwania duplikatów nie jest wysoki.

C. Okres przechowywania danych: Im dłuższy okres przechowywania danych, tym bardziej opłacalna staje się eliminacja duplikatów, ponieważ może znacznie zmniejszyć wymagania dotyczące miejsca przechowywania.

Tworzenie racjonalnej strategii tworzenia kopii zapasowych w celu zmniejszenia duplikacji danych

Aby stworzyć racjonalną strategię tworzenia kopii zapasowych w celu zmniejszenia duplikacji danych, można podjąć następujące działania:

1. Łącz kopie pełne i przyrostowe: Wykonuj kopie pełne na początku lub po ważnych aktualizacjach danych, aby uzyskać pełny obraz danych; stosuj kopie przyrostowe codziennie, aby zapisywać nowe zmiany, zmniejszyć ilość zduplikowanych danych i oszczędzić zasoby.

2. Wdrażanie polityk archiwizacji i czyszczenia: Skonfiguruj regularne plany archiwizacji w celu przenoszenia rzadko używanych, ale niezbędnych danych do taniego miejsca przechowywania; zidentyfikuj i usuń dane powtarzające się lub nieaktualne, ustal okresy przechowywania danych oraz zautomatyzuj proces czyszczenia.

3. Optymalizuj proces tworzenia kopii zapasowych: Wybierz oprogramowanie do tworzenia kopii zapasowych obsługujące deduplikację, które automatycznie usuwa zduplikowane dane podczas tworzenia kopii; skompresuj i zaszyfruj dane archiwalne, aby dodatkowo zaoszczędzić miejsce i wzmocnić bezpieczeństwo.

4. Ciągłe monitorowanie i dostosowywanie strategii: Regularnie sprawdzaj skuteczność danych kopii zapasowych, monitoruj wykorzystanie pamięci masowej oraz w razie potrzeby dostosowuj strategię tworzenia kopii zapasowych i archiwizacji zgodnie ze zmianami w działalności firmy, aby zapewnić skuteczne działanie i zgodność z wymogami.

Które oprogramowanie do tworzenia kopii zapasowych jest najlepsze?

Vinchin Backup & Recovery jest profesjonalnym oprogramowaniem do tworzenia kopii zapasowych maszyn wirtualnych, które obsługuje ponad 10 platform wirtualizacji, w tym VMware, Hyper-V, Proxmox, XenServer i oVirt itp. Udostępnia doskonałe funkcje tworzenia kopii zapasowych i odzyskiwania maszyn wirtualnych oraz umożliwia migrację między platformami.

Oczywiście, Vinchin Backup & Recovery obejmuje również funkcje deduplikacji i kompresji. Ofertuje funkcję deduplikacji z niestandardową wielkością bloku, która jest bardziej korzystna niż tradycyjna, stała deduplikacja, skutecznie zmniejszając zużycie miejsca na przechowywanie kopii zapasowych.

Adoptując technologię Vinchina w zakresie eliminacji zduplikowanych danych i kompresji, można zwiększyć prędkość tworzenia kopii zapasowych w procesie zapisu danych oraz zmniejszyć zużycie zasobów pamięciowych przez dane kopii zapasowej. Dodatkowo zmniejsza to ryzyko globalnego uszkodzenia danych spowodowanego globalną eliminacją zduplikowanych danych.

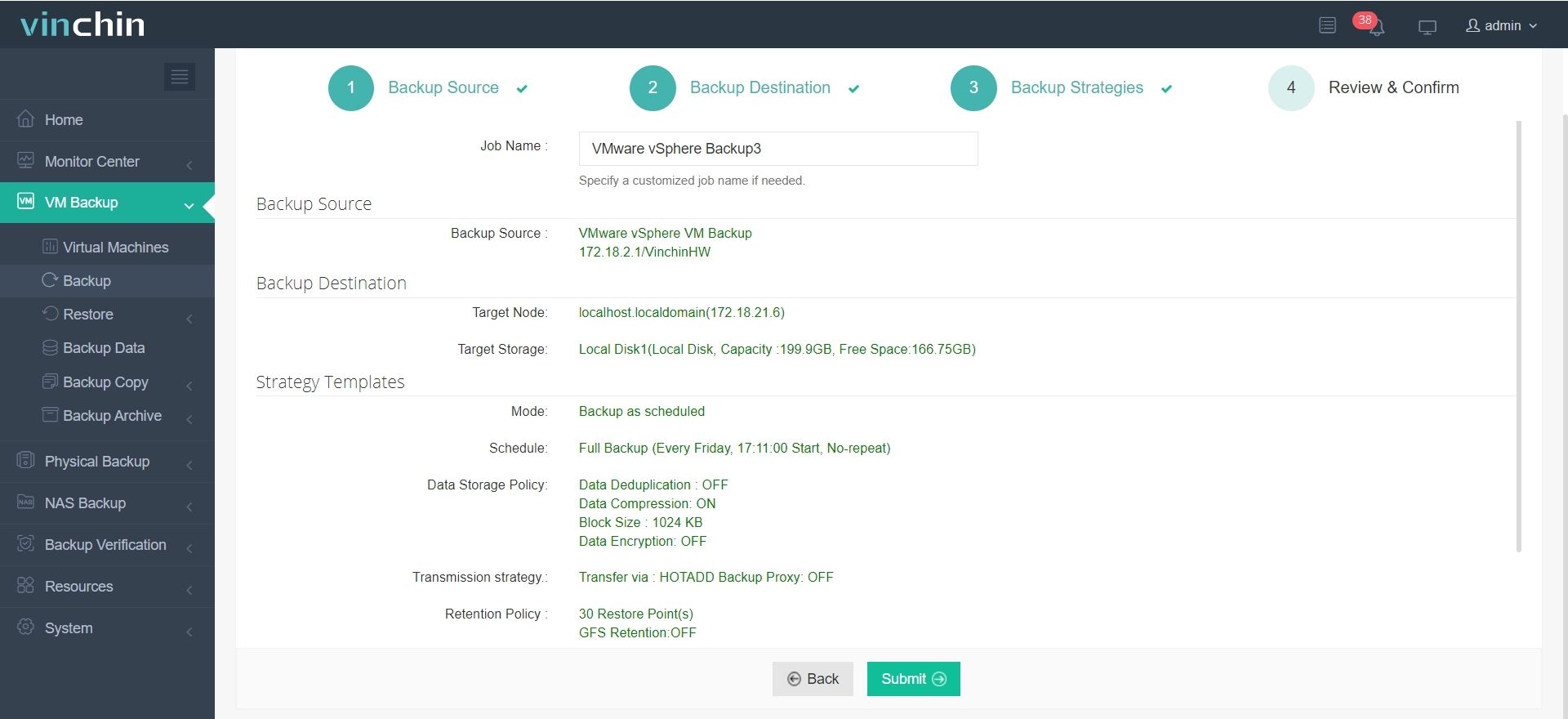

Aby włączyć usuwanie zduplikowanych danych podczas tworzenia kopii zapasowej, należy wykonać następujące kroki:

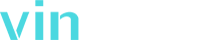

1. Wybierz maszynę wirtualną, którą chcesz utworzyć kopię zapasową.

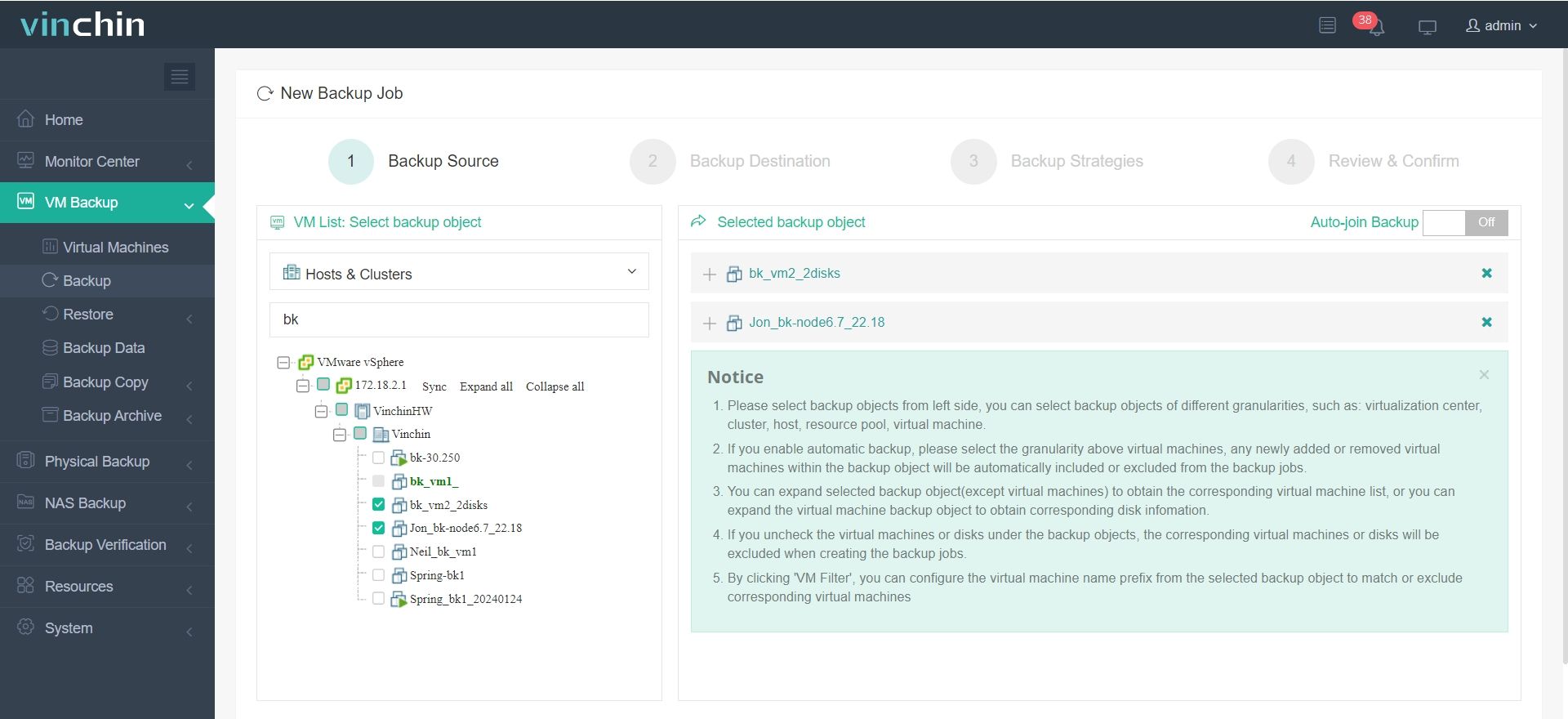

2. Wybierz miejsce docelowe kopii zapasowej.

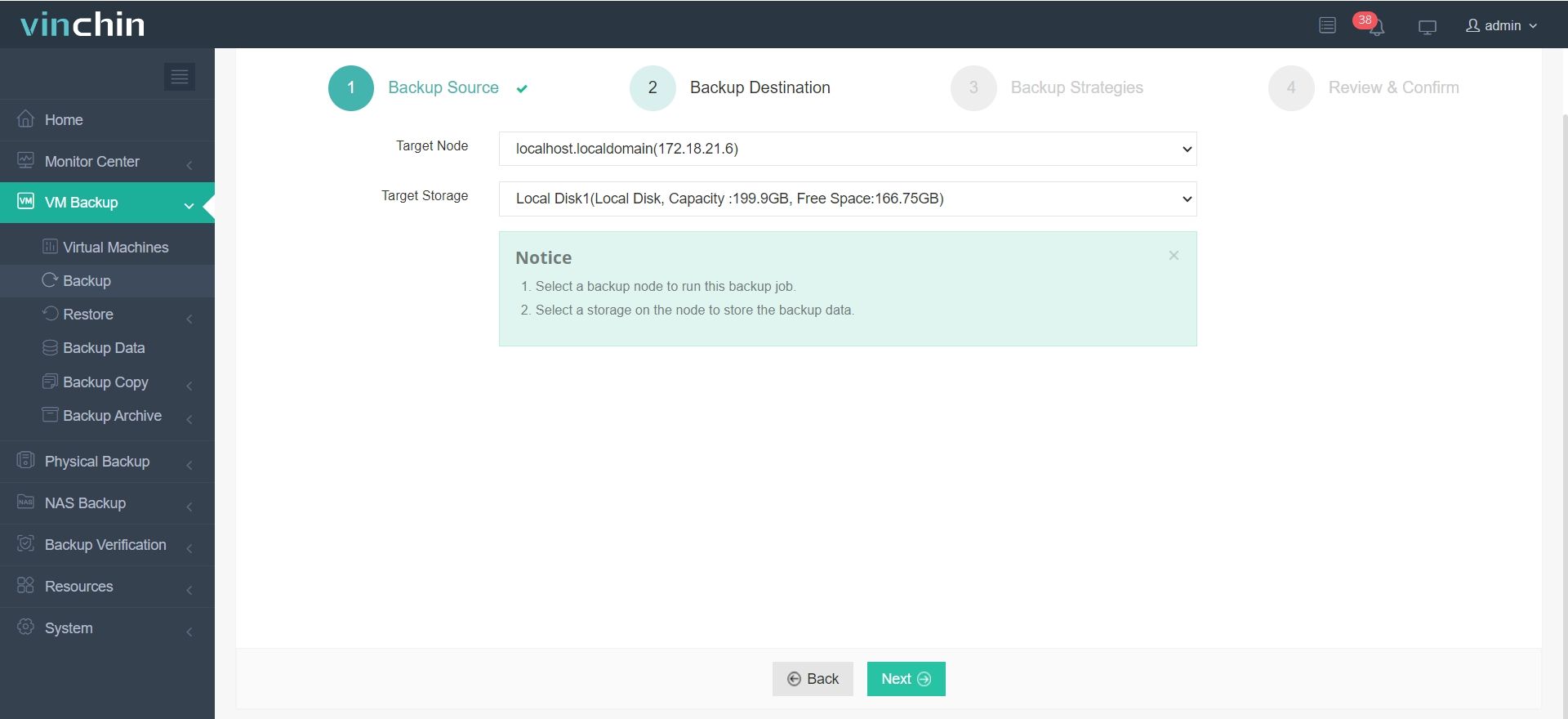

3. Skonfiguruj strategie kopii zapasowych.

W sekcji "Zasady przechowywania danych" można wybrać, czy włączyć funkcję eliminacji zduplikowanych danych i kompresji.

4. Potwierdź zadanie kopii zapasowej.

Oprócz wymienionych funkcji, Vinchin oferuje wiele innych zaawansowanych funkcji, które czekają, aż je odkryjesz. Kliknij przycisk poniżej, aby rozpocząć 60-dniowy bezpłatny okres próbny z pełnymi funkcjami!

Kompresja danych w procesie tworzenia kopii zapasowych — Często zadawane pytania

1. P: Jakie dane nadają się do kompresji, a jakie nie?

A: Usuwanie duplikatów jest odpowiednie dla każdego rodzaju danych, w tym dokumentów biurowych, baz danych, plików multimedialnych i maszyn wirtualnych. Chociaż niektóre dane mogą nie wykazywać znaczącego efektu usuwania duplikatów podczas pierwszego kopii zapasowej ze względu na swoją naturę, to zalety usuwania duplikatów stają się widoczne w kolejnych kopii zapasowych. Im częściej wykonywane są kopie zapasowe i im krótsze są między nimi odstępy czasowe, tym wyższy jest wskaźnik usuwania duplikatów.

2. Q: Co to jest usuwanie zduplikowanych danych o stałej długości bloku, a co o zmiennej długości bloku?

A: Usuwania zduplikowanych danych o stałej długości bloków polega na podziale danych na bloki o ustalonej wielkości i identyfikowaniu duplikatów poprzez porównywanie zawartości każdego bloku. Ta metoda jest prosta, jednak może nie wykryć możliwości eliminacji redundancji, jeśli identyczne dane przesuną się nieco. Z kolei usuwanie zduplikowanych danych o zmiennej długości bloków dzieli dane na bloki o różnej wielkości w oparciu o wzorce zawartości, co pozwala na bardziej precyzyjne wykrywanie duplikatów nawet w przypadku przesunięcia danych. Dzięki temu usuwanie zduplikowanych danych o zmiennej długości bloków jest skuteczniejsze w zmniejszaniu zużycia miejsca do przechowywania, choć jest bardziej złożone w realizacji.

Podsumowanie

Dane zduplikowane nie tylko marnują miejsce na dysku, zwiększając koszty operacyjne przedsiębiorstw, ale również mogą wpływać na efektywność tworzenia kopii zapasowych i odzyskiwania danych, komplikując zarządzanie danymi. Dlatego stosowanie skutecznych technologii eliminowania duplikatów w celu zmniejszenia ilości powtarzających się danych ma kluczowe znaczenie. Dzięki deduplikacji przedsiębiorstwa mogą zoptymalizować wykorzystanie przestrzeni dyskowej, obniżyć koszty oraz poprawić efektywność i dokładność zarządzania danymi.

Udostępnij: